信息论速成1

信息论的形成、发展及主要内容

信息论的形成、发展及主要内容一、引言信息论是一门研究信息传输、存储和处理的科学,其应用范围涵盖了通信、数据压缩、密码学等多个领域。

本文将介绍信息论的起源、经典信息论的发展、现代信息论的突破以及信息论在各个领域的应用。

二、信息论的起源信息论的起源可以追溯到20世纪初,当时电信和广播业开始快速发展,需要有一种度量信息的方法。

1928年,美国数学家哈特利提出用消息发生的概率来定义消息的熵,从而为信息论的发展奠定了基础。

三、经典信息论的发展1948年,美国数学家香农在《贝尔系统技术》杂志上发表了经典论文《通信的数学理论》,标志着信息论的诞生。

香农提出了信息的度量方法,即信息熵,并且给出了信息的传输速率的上限。

此外,香农还研究了信息的存储和检索问题,提出了数据压缩的理论基础。

四、现代信息论的突破随着技术的发展,现代信息论在经典信息论的基础上有了新的突破。

首先,现代信息论不仅关注信息的传输和存储问题,还关注信息的处理和理解问题。

其次,现代信息论引入了更多的数学工具和概念,如概率图模型、贝叶斯网络等,使得信息论的应用更加广泛和深入。

五、信息论在通信中的应用信息论在通信领域的应用是最为广泛的。

例如,香农的信道编码定理告诉我们,在传输过程中可以通过增加冗余信息来降低错误概率,从而提高通信的可靠性。

此外,信息论还被应用于调制解调、信号检测和同步等领域。

六、信息论在数据压缩中的应用数据压缩是信息论的一个重要应用领域。

通过去除数据中的冗余信息,数据压缩可以减小数据的存储空间和传输时间。

例如,香农提出的哈夫曼编码是一种有效的无损数据压缩算法,被广泛应用于图像、视频和音频数据的压缩。

七、信息论在密码学中的应用密码学是信息安全领域的重要分支,而信息论为其提供了理论基础。

在密码学中,信息论用于分析信息的保密性、认证性、完整性和可用性等安全属性。

例如,基于信息熵的加密算法可以用于评估加密数据的保密性程度。

此外,信息论还被应用于数字签名、身份认证等领域。

第二章信息论

第三节

信息的量化

一、概率的概念及有关知识 1、申农关于信息量化的观点 完全撇开信息的具体内容,也不考虑主观 因素对信息的影响,把信息加以形式化,用信 息发生的概率对信息进行量化。 2、自然现象的分类 必然事件:在一定条件下必然发生的现象 不可能事件:在一定条件下不会发生的现象 随机事件:在一定条件下可能发生,也可能不发生的

第二章 信息论

第一节 第二节 第三节 第四节 第五节 信息概述 信息论的基础知识 信息的量化 信息方法 信息科学技术和信息革命

信息论最初是一种专业性很强的通信理论, 主要研究通信领域中的信息的量化问题。后 来由于信息的普遍性和信息论的广泛应用, 信息论发展成为新兴的边缘学科—信息科学。 信息论是研究信息的产生、识别、获取、 传输、存储、处理和利用的理论和技术,主 要解决对信息的认识问题,研究信息的描述 和度量以及信息传输的理论。

申农信息定义

信息是用来消除不确定性的东西

维纳信息定义

信息就是人和外界相互作用的过程中相互交换的内容总称。

维纳信息定义的改进

信息是控制系统进行调节活动时与外界相互作用、相互 交换的内容。

通讯领域

信息是关于客观事物的可通讯的知识。

系统开发领域

信息是经过加工处理的具有特定含义的数据,它对使用 者的行为具有现实的或者潜在的价值。

第二节

信息论基础知识

一、通信系统模型 1、通信系统模型

申农认为通信应该是信息在系统中识别、 传输、变换、存储、处理、显示的过程。因此 通信系统必须是一个发送与接收,输入与输出 两者相互联系的不可分割的统一体。

通信系统模型

通信的基本问题是在彼时彼地精确地或近似地再现此时此 地发出的消息。 各种通信系统,一般可概括为下图所示的统计模型:

信息论第1章

第一章信息的定性描述第一节对信息的初步认识一. 信息社会当今,世界上信息革命的热潮一浪高过一浪。

近年来,移动电话、个人电脑和网络用户正以高于摩尔定律的速度迅猛增长。

人们都在谈论着信息社会、信息革命和网络时代,信息似乎成了个很时髦的字眼儿。

就连中国人平常打招呼的话“你吃饭了吗?”也被有些人改成“你上网了吗?”但这绝不是什么赶时髦,也绝不是什么偶然现象,而是社会发展的必然趋势。

因为在信息社会里,人们最关心的是信息问题,而不是吃饭问题。

“民以食为天”的信条将会逐渐被“民以信为天”所代替。

社会学家和未来学家普遍认为,20世纪末和21世纪初,是信息革命爆发的时期。

一些新技术的突破和新产业的出现,使社会生产力发生了新的飞跃,人们的生活也发生了新的变化,人类社会正在进入信息化社会。

所谓信息化社会,就是以信息产业为中心,使社会生产、生活和经济都发展起来的社会。

在这种社会中,◆信息成了比物质或能源更为重要的资源,◆对信息产业成了重要的产业。

◆从事信息工作者成了主要的劳动者。

◆信息和知识成了生产力发展的决定因素。

二. 信息的普遍性其实,信息并不是什么新鲜东西,信息无时不在,无处不有。

人们生活在信息的海洋里,天天都要通过自己的感觉器官感受各种外界信息。

例如,衣食住行,读书看报,听广播,看电视等等。

人们要进行社会活动就需要有信息交流。

例如,除了书信、电话、电报之外,天天都要同许多人交谈、交往。

人们还要进行信息处理和存储。

例如,要把观察、接收到的大量事物、数据和资料进行分类、分析、整理和纪录。

不仅如此,信息也是人类自身进化的一个基本条件。

恩格斯对于人类的进化过程,曾有过这样一段极其精彩的描述:“……这些猿类,大概是首先由于它们生活方式的影响……渐渐直立行走……手变得自由了……随着手的发展,随着劳动而开始的人对自然的统治,在每一个新的发展中扩大了人的眼界。

……另一方面,劳动的发展必然促使社会成员更加紧密地互相结合起来,因为它使互相帮助和共同协作的场合增多了,并且使每个人都清楚地意识到这种共同协作的好处。

信息论速成2

信源

X1X2…XN…

Xi可能取那些消息符号是事先确定的,当前是什么 消息符号是不确定的,但知道取各个符号的概率。

信息理论基础

第三章

离散信源

①、离散信源 信源输出是离散的消息符号,可用离散随机变量 描述。最简单的离散信源可用一维离散随机变量来描 述的,其数学模型为

信息理论基础

第三章

内容提要

离散信源

§3.1 信源的数学模型及其分类

§3.2 离散无记忆信源

§3.3 离散无记忆信源的扩展信源

§3.4 离散平稳信源

§3.5 马尔可夫信源

信息理论基础

第三章

离散信源

通信的根问题是在接收端尽可能精确地再现出信 源的输出,本章讨论如何描述信源的输出,也就是如 何计算信源产生的信息量。 §3.1 信源的数学模型和分类

p(ai ) 0 , i 1, 2,, q

例如二元离散信源

p(a ) 1,

i 1 i

q

X 0 1 P p q p 0, q 0 p q 1

信息理论基础

第三章

离散信源

2、简单离散无记忆信源的信息熵 ①、自信息量 简单离散无记忆信源中,消息符号ai的自信息量为

信息理论基础

第三章

X 1 p(α) p( ) 1

离散信源

2 p( 2 ) 3 4 p(3 ) p( 4 )

二进制离散无记忆信源二次扩展信源的数学模型为

其中, 1=00, 2=01, 3=10, 4=11

p(l ) P( X l ) P( X k aik ) pik

信息论的基本概念

信息论的基本概念嘿,朋友!咱今天来聊聊信息论这玩意儿。

你知道吗?信息论就像一个神秘的宝藏盒子,里面装满了让人惊奇的宝贝。

比如说,信息是什么?它可不是简单的文字、图像或者声音,而是一种能够消除不确定性的东西。

就好像你在黑暗中摸索,突然有人给你点亮了一盏灯,那种一下子看清周围的感觉,就是信息的作用。

想想看,我们每天都在接收各种各样的信息,比如朋友的问候,新闻的报道,甚至是路边的广告。

但这些信息的价值可不一样。

有的信息能让你做出重要的决定,有的可能只是过眼云烟。

这就好比在一堆石头里找宝石,有的石头普普通通,而有的宝石却能让你眼前一亮。

信息论里还有个重要的概念叫熵。

这熵可不是什么好对付的家伙,它代表着混乱和不确定性。

比如说一个杂乱无章的房间,东西到处乱丢,这就是熵很高的状态。

而当你把房间整理得井井有条,熵就降低啦。

信息的传递也是个有趣的过程。

它就像是一场接力赛,信息从发送者那里出发,经过各种渠道,最后到达接收者手里。

可这一路上,信息可能会受到干扰,就像接力棒可能会掉在地上一样。

要是干扰太大,接收者收到的信息可能就变了样,这可就麻烦啦!信息的编码和解码也很有讲究。

编码就像是给信息穿上一件特别的衣服,让它能更顺利地通过各种关卡。

解码呢,就是把这件衣服脱掉,还原出原本的信息。

要是编码和解码出了问题,那信息可就变得面目全非啦。

再说信息的度量,这就像是给信息称重量。

不同的信息,重要程度、价值大小都不一样,所以它们的“重量”也不同。

信息论在我们的生活中可太有用啦!比如说通信领域,没有信息论,我们怎么能享受到清晰流畅的电话通话和快速的网络呢?还有在数据压缩方面,它能让我们把大量的信息压缩得小小的,节省存储空间。

朋友,你难道不觉得信息论就像一个神奇的魔法,在不知不觉中影响着我们的生活吗?好好去感受它的魅力吧!信息论,这个看似高冷的家伙,其实就在我们身边,为我们的生活带来便利和惊喜。

信息论第1章25页PPT

信道编码的主要作用是提高信息传送的可靠性

01.11.2019

22

三码合一

密码学研究的内容

如何隐蔽消息中的信息内容,使它在传输过 程中不被窃听,提高通信系统的安全性。

从理论方面来说,若能把三种码合并成一种码 来编译,即同时考虑有效、可靠和安全,可使 编译码器更理想化,在经济上可能也更优越。

信息是消息的内涵,是信号的价值,信息 是能使信宿得以获知解惑的东西。

它应当是从千千万万不同形式不同内容的 消息中抽象出来的、具有共性的、可定量 测度的一个量,应该有它的单位和数学表 达。

01.11.2019

11

消息、信号和信息

例一:扔硬币

正反面不确定

例二:天气预报

晴、多云、雨、雪、风:不确定

15

信息的特征

8. 信息的可加工性 9. 信息的可再现性 10. 信息的可存储性 11. 信息的积累性 12. 信息的延续性和继承性 13. 信息的可开发性 14. 信息的可再生性和可增值性

01.11.2019

16

信息的性质

性质一:普遍性

信息是普遍存在的。

性质二:无限性

在整个宇宙时空中,信息是无限的。

01.11.2019

5

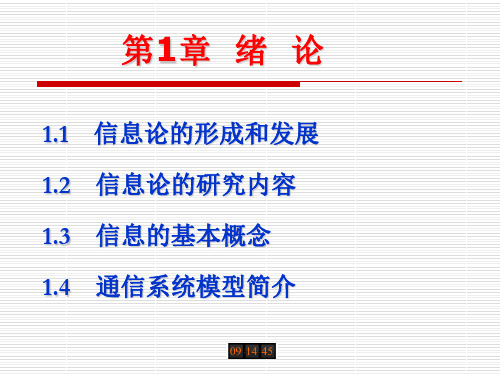

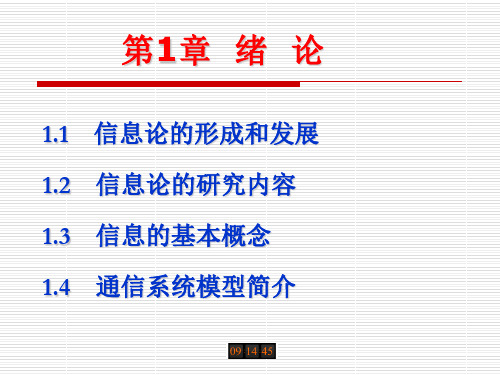

1.2 信息论的研究内容

√ 狭义信息论(经典信息论)

主要研究信息的测度、信道容量及信源和信道编码理论等问 题,又称香农基本理论

一般信息论(工程信息论)

主要研究信息传输和处理问题。除香农理论以外,还包括编 码理论、噪声理论、信号滤波和预测、统计检测和估计、调 制理论、信息处理理论以及保密理论等

信息论第1章 25页

母病愈 ,勿念

26.11.2019

21

信道编码器与译码器

信道编码器的作用 母病▓ ,勿念

在信源编码器输出的代码组上有目的地增加一些监 督码元,使之具有检错或纠错的能力。

信道译码器的作用

Without energy, nothing happens. 没有能源的世界是死寂的世界

Without information, nothing makes sense. 没有信息的世界是混乱的世界

26.11.2019

8

信息的定义

从日常生活知识来理解

英国牛津字典:信息是谈论的事情、新闻和知识 韦氏字典:在观察研究过程中获得的数据情报、新闻和知识 日本广辞苑:信息是所观察事物的知识

定长编码 变长编码

定理

定理

有噪声 信道编码理论

网络信道

保密系统的 信息理论

网络信息理论

压缩编码

最优码构成 Huffman码

Fano码

码构成 纠错码

网络最佳码

保密码

26.11.2019

代数编码 卷积码

7

1.3 信息的基本概念

物质世界的三大支柱:物质、能量和信息

Without materials, there is nothing. 没有物质的世界是虚无的世界

信宿

干扰 噪声源

26.11.2019

18

数字通信系统模型

信源 信源编码

加密 信道编码

加密 密钥

信

解密 密钥

道

信宿 信源解码

解密 信道解码

干扰源

26.11.2019

19

信息论

信息论信息论是一门研究信息传输和处理的学科,它涉及信号的传输、存储和处理,以及信息的量化和表示等方面。

信息论的概念最早由美国数学家克劳德·香农于1948年提出,它是通信工程和计算机科学的基础理论之一。

信息论的研究对象是信息。

那么什么是信息呢?根据香农的定义,信息是一种排除干扰的度量,它代表了一个事件的不确定性的减少。

信息的传递需要通过信号来实现,信号是用来传递信息的载体。

在传输过程中,信号可能会受到各种干扰的影响,导致信息的丢失或损坏。

信息论的目标就是通过对信号和信息的处理,使得信息的传输更加可靠和高效。

在信息论中,最基本的概念之一是熵。

熵是信息的度量方式,它表示了信源输出的平均信息量。

当一个信源的输出是均匀分布的时候,熵达到最大值;当一个信源的输出是确定的时候,熵达到最小值。

通过对信源的编码,可以将信息进行压缩,从而提高信息的传输效率。

除了熵,信息论中还有一个重要的概念是信道容量。

信道容量是指在给定的传输条件下,一个信道可以传输的最大信息量。

在通信系统设计中,我们需要选择合适的调制方式和编码方式,以使得信道的传输容量最大化。

信息论还涉及到误差校正编码、数据压缩、信源编码等方面的研究。

误差校正编码是一种技术,通过在发送端对信息进行编码,并在接收端对接收到的信息进行解码,可以检测和纠正传输过程中产生的错误。

数据压缩则是通过对信息进行编码,去除冗余信息,从而减少信息的存储和传输所需的空间和带宽。

信源编码是一种特殊的数据压缩技术,它通过对信源输出进行编码,从而减少信息传输所需的位数。

信息论的理论研究与实际应用密切相关。

例如在无线通信中,研究如何提高信道利用率和减少传输功耗;在数据存储与传输中,研究如何提高数据压缩比和减小数据传输延迟等。

信息论的成果不仅在通信工程和计算机科学领域有广泛的应用,同时也为其他学科的研究提供了理论基础。

总之,信息论的研究旨在探索信息的传输和处理规律,为信息的存储、传输和处理提供有效、可靠的技术和方法。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

信息理论基础

第一章

4、信息、消息和信号

绪论

信息:①、比较抽象的概念; ②、是通信系统中传送的对象; ③、包含在消息中。 消息:①、消息比较具体,但不是物理的;

②、消息有不同的形式,能被人的感觉感知;

例如:语言、文字、符号、数据、图片等

③、构成消息的条件:

*能被通信双方理解 *可以传递

信息理论基础

组成部分:信源译码器——第五章 信道译码器——第六章

⑥、信宿:信息传送过程中的接收者,即接收信息的 人或物。

信息理论基础

信息理论课程讲授的核心内容:

香农三大定理

1、第一定理:信源编码定理(第五章) 解决信息传输的有效性——最有效的方法。

2、第二定理:有噪信道编码定理(第六章) 解决信息传输的可靠性——最可靠的方法。

信息理论基础

第一章

③、信道:

绪论

定义:将信号从发端传到收端的媒质或通道;

信道种类:电话线、电缆、光纤、电波等。

信道的主要研究内容——第四章 *数学模型:简单、扩展、组合信道 *平均互信息 *级联信道的信息不可增加性 *信道容量

信息理论基础

第一章

④、干扰源:

绪论

定义:系统所有噪声和干扰等效成信道干扰;

I(xi | yj) = – log p(xi | yj)

释:①、I(xi)是事件xi本身所具有的不确定性;

②、I(xi | yj) 是事件yj 发生后, 事件xi 尚存在的不 确定性; ③、条件自信息量单位同自信息量。

信息理论基础

第二章

一、互信息量

信息的统计度量

§2.2 互信息量和条件互信息量

1、定义:事件xi 和事件yj之间的互信息量定义为

3、第三定理:限失真信源编码定理(第七章) 解决信源的信息在失真准则下进行压缩的极限。 信息传输定理(信息处理定理):

4、信息在传输、存贮和处理过程中的不可增加性 (第四章)

信息理论基础

第二章

内容提要

信息的统计度量

§2.1 自信息量和条件自信息量

§2.2 互信息量和条件互信息量

§2.3 离散集的平均自信息量

信源 信源编码器 纠错编码器 调制器

信道

干扰源

信宿Βιβλιοθήκη 信源译码器纠错译码器

解调器

信息理论基础

第一章

简化模型

信源 消息

绪论

译码器

信宿 消息

编码器

信道 信号 信号 干扰 干扰源

①、信源: 定义:产生消息的源(消息序列); 消息:消息是文字、语言、图像等; 消息可以是离散的,或连续的; 消息是随机的,用随机变量或随机过程表示; 信源研究的主要问题——第三章 消息的统计特性; 信源产生消息的速率。

1 (Hat) = log210 (Bits) = 3.322 (Bits)

④、p(xi)小 → 不确定性大 → 信息量大 p(xi)大

→

不确定性小 → 信息量小

信息理论基础

第二章

2、联合事件

信息的统计度量

定义:假设二维联合集合XY上元素(xi , yj)发生概率为 p(xi , yj),则其自信息量定义为

§2.4 离散集的平均互信息量

信息理论基础

第二章

一、自信息量

1、简单事件

信息的统计度量

§2.1 自信息量和条件自信息量

定义:假设任意简单随机事件xi的发生概率为p(xi), 则自信息量定义为

I(xi) = - log p(xi)

释:①、由于p(xi)≤1,取“-”号使得I(xi)≥0; ②、自信息量I(xi)的物理意义: 当事件xi发生前,表示该事件发生的不确定性; 当事件xi发生后,表示该事件所提供的信息量。

信息理论基础

第一章

美国人 阿拉伯人 中国人 植物人

绪论

信息和消息不一样,同一条消息可产生不同的效果:

911事件是消息

信息理论基础

第一章

2、广义的信息概念

绪论

①、信息表征客体变化、客体之间的差异和关系; 客观世界三大要素:物质、能量、信息 物质运动需要能量,运动产生差异,差异产生信息。 没有完全一样的客观物体: 例如:双胞胎兄弟难区分—母亲能区分,存在差异。 ②、信息表征客体的行为和能力,而不是客体本身。

信息理论基础

第一章

②、编码器:

绪论

定义:将信源发出消息变换成适于信道传送的设备; 组成部分:信源编码器、纠错编码器、调制器; 信源编码器:对信源输出的消息进行变换(信源压缩) 提高传输有效性——第五章、第七章

纠错编码器:对信源编码器输出的消息进行变换 提高传输可靠性——第六章、(第九章) *提高有效性和可靠性是通信系统的根本问题 调制器:将纠错编码器输出的消息变换成适于信道传 输的信号。

I(xi ; yj) = log [p(xi | yj)/p(xi)]

释:①、I(xi ; yj) = [– log p(xi)] – [– logp(xi | yj)] = I(xi) – I(xi | yj) = 先验的不确定性 – 尚存在的不确定性 ②、表示事件xi 发生后传递给事件yj的信息量; 表示事件yj发生所能提供的关于事件xi的信息量。

信息理论基础

信

息

论

考试方式:期末闭卷 授课教师:李 景 文 教材:信息理论基础

北京航空航天大学出版社

教材主编:周荫清

信息理论基础

第一章

主要内容 §1.1 信息论

绪论

§1.2 信息

§1.3 通信系统数学模型

信息理论基础

第一章

§1.1 信息论

绪论

信息论:应用数理统计的方法研究信息的传输、 存储和处理的一门学科。经典信息论、广义信息论、 信息科学。 1、经典信息论 又称为数学信息论、狭义信息论、近代信息论、 香农信息论。 创始人:美国工程师C.E.Shannon(香农)。

1、概率论的核心概念是随机变量。

随机变量的精确描述是分布律和概率密度。

随机变量的粗略描述是数字特征(均值和方差)。 2、信息论的核心概念是信息。 信息的精确描述是信息量(自信息量、条件自信息 量和互信息量)。

信息的粗略描述是什么?——熵

信息理论基础

第二章

信息的统计度量

二、定义:在离散集X上,随机变量I(xi)的数学期望定 义为平均自信息量

信息理论基础

第二章

信息的统计度量

③、单位:取决于对数以什么为底

*比特(Bit): I(xi) = - log2 p(xi) = - lb p(xi)

如:p(xi) = 0.5,则I(xi) = - lb 0.5 = 1 (Bit) *奈特(Nat):I(xi) = - loge p(xi) = - ln p(xi) 1 (Nat) = log2e (Bits) = 1.443 (Bits) *哈特莱(Hat):I(xi) = - log10 p(xi) = - lg p(xi)

信息理论基础

第一章

绪论

3、概率信息——定量描述 又称为香农信息、狭义信息,由香农提出来的, 从事件不确定性(随机性)和概率测度出发定义信息。

例如:

甲袋(100个球) 红(50)、白色(50) 随意取出一球为红色 | 不确定性小、概率大(1/2) | 当被告知取出球为红色 (不确定性没有了) | 消除的不确定性少 (获得信息少) 乙袋(100个球) 红(25)、白(25)、兰(25)、黑(25) 随意取出一球为红色 | 不确定性大、概率小(1/4) | 当被告知取出球为红色 (不确定性没有了) | 消除的不确定性多 (获得信息多)

即事件yj的发生有助于肯定事件xi的发生。

若 p(xi | yj) < p(xi),则I(xi ; yj) < 0

即事件yj的发生不利于肯定事件xi的发生。

④、I(xi ; yj) ≤ I(xi)

I(xi ; yj) ≤ I(yj)

即任何两事件的互信息量不能大于其中任一事件的自信息量。

信息理论基础

干扰种类:加性干扰、乘性干扰;

加性干扰:与信道输入统计无关 如内部噪声等; *输出信号是输入信号与加性干扰相加的结果。 乘性干扰:与信道输入信号大小或特性有关 如放大器放大倍数受温度影响; *输出信号是输入信号与乘性干扰相乘的结果。

信息理论基础

第一章

⑤、译码器:

绪论

定义:从信道输出的受到干扰的信号中最大限度提取 信源输出消息的信息; *如果没有干扰——信息无损失(如无失真信源编码) *如果存在干扰——信息有损失(如限失真信源编码、 有噪信道编码)

第二章

二、条件互信息量

信息的统计度量

事件zk给定条件下,事件xi 和事件yj之间的互信息 量定义为条件互信息量

I ( xi ; y j | zk ) log

p ( xi | y j zk ) p ( xi | zk )

释:①、I(xi ; yj zk) = I(xi ; zk) + I(xi ; yj | zk)

信息理论基础

第一章

§1.2 信息

1、通俗的信息概念

绪论

最普通的概念:信息是一种消息。

例如有人告诉你一条消息。(获得信息?获得多少?) ①、包含许多原来未知的新内容——信息量大 例如:信息论这门课期末不考试——信息量大 ②、包含许多原来知道的旧内容——信息量小 例如:信息论这门课期末考试——信息量小

②推广:

I ( x; yy1 y2 ... yn ) I ( x; y ) I ( x; y1 | y ) I ( x; y2 | yy1 ) ... I ( x; yn | yy1 y2 ... yn 1 )

信息理论基础

第二章

一、引入

信息的统计度量

§2.3 离散集的平均自信息量

1948年,《A Mathematical Theory of Communication》