线性判别分析

第8章-线性判别分析--机器学习与应用第二版

第8章线性判别分析主成分分析的目标是向量在低维空间中的投影能很好的近似代替原始向量,但这种投影对分类不一定合适。

由于是无监督的学习,没有利用样本标签信息,不同类型样本的特征向量在这个空间中的投影可能很相近。

本章要介绍的线性判别分析也是一种子空间投影技术,但是它的目的是用来做分类,让投影后的向量对于分类任务有很好的区分度。

8.1用投影进行分类线性判别分析(Linear discriminant analysis,简称LDA)[1][2]的基本思想是通过线性投影来最小化同类样本间的差异,最大化不同类样本间的差异。

具体做法是寻找一个向低维空间的投影矩阵W,样本的特征向量x经过投影之后得到新向量:y Wx=同一类样本投影后的结果向量差异尽可能小,不同类的样本差异尽可能大。

直观来看,就是经过这个投影之后同一类的样本尽量聚集在一起,不同类的样本尽可能离得远。

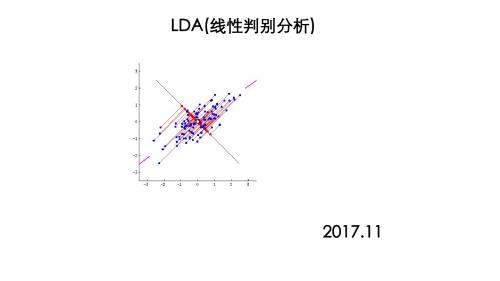

下图8.1是这种投影的示意图:图8.1最佳投影方向上图中特征向量是二维的,我们向一维空间即直线投影,投影后这些点位于直线上。

在上图中有两类样本,通过向右上方的直线投影,两类样本被有效的分开了。

绿色的样本投影之后位于直线的下半部分,红色的样本投影之后位于直线的上半部分。

由于是向一维空间投影,这相当于用一个向量w和特征向量x做内积,得到一个标量:Ty=w x8.2寻找投影矩阵8.2.1一维的情况问题的关键是如何找到最佳投影矩阵。

下面先考虑最简单的情况,把向量映射到一维空间。

假设有n 个样本,它们的特征向量为i x ,属于两个不同的类。

属于类1C 的样本集为1D ,有1n 个样本;属于类2C 的样本集为2D ,有2n 个样本。

有一个向量w ,所有向量对该向量做投影可以得到一个标量:T y =w x投影运算产生了n 个标量,分属于与1C 和2C 相对应的两个集合1Y 和2Y 。

我们希望投影后两个类内部的各个样本差异最小化,类之间的差异最大化。

类间差异可以用投影之后两类样本均值的差来衡量。

线性判别分析算法在分类任务中的应用

线性判别分析算法在分类任务中的应用在机器学习领域中,分类任务是一个非常重要的应用领域。

通过机器学习算法对数据进行分类,能够帮助我们更好地理解数据,并且在实际应用中能够帮助我们快速准确地对未知数据进行分类。

其中,线性判别分析算法能够在一些常见的分类任务中发挥重要作用。

一、线性判别分析算法的基本原理线性判别分析,也称为Fisher线性判别,是一种经典的分类算法,它能够将数据进行降维,从而更容易地对数据进行分类。

其基本思路是,对于给定的数据,我们首先将其进行投影,从原始空间投影到一个较低维的空间中,使得在这个新空间中,数据点之间的距离最大化,并且同类数据点之间的距离最小化。

在这个过程中,我们需要寻找一个线性变换矩阵$W$,将原始空间中的数据$x$,变换到新的空间中$y$,即:$y=WX$其中,$X$是原始空间中的$n$维向量,$y$是新空间中的$d$维向量。

在这个过程中,我们要最大化两个指标,即类间距离和类内距离。

对于类间距离,我们希望不同类别之间的数据点更加分散,从而让分类更加准确。

我们可以定义一个类间距离的矩阵$S_B$,其为所有类别之间的数据点协方差矩阵的加权和,即:$S_B=\sum_{i=1}^kw_i(\mu_i-\mu)(\mu_i-\mu)^T$其中,$k$是类别数量,$w_i$是第$i$个类别中数据点数量,$\mu_i$是第$i$个类别的均值向量,$\mu$是所有数据点的均值向量。

对于类内距离,我们希望同一类别之间的数据点更加紧密,从而提高同类别数据点之间的相似度。

我们可以定义一个类内距离的矩阵$S_W$,其为所有类别内部数据点协方差矩阵的加权和,即:$S_W=\sum_{i=1}^kw_iS_i$其中,$S_i$是第$i$个类别的协方差矩阵,$w_i$是第$i$个类别中数据点数量。

类别数量越多,$S_W$的值就越大,数据进行降维时,对角线上的元素是降维后数据的方差,越小意味着降维后数据的区分度就越好,所以也就有了$J(W)$(评价指标)的定义:$J(W)=\frac{\mid W^TS_BW \mid}{\mid W^TS_WW \mid} $为了最大化类间距离和最小化类内距离,我们需要求解出最佳的投影矩阵$W$,使得$J(W)$最大。

统计学中的判别分析方法

统计学中的判别分析方法统计学是一门研究数据收集、分析和解释的学科,可以帮助我们更好地理解和利用数据。

判别分析是统计学中一种重要的方法,它可以用于解决分类问题和区分不同的群组。

本文将介绍判别分析的基本概念、应用场景以及常见的判别分析方法。

一、判别分析的基本概念判别分析(Discriminant Analysis)是一种用于确定某个变量(被称为判别变量)对于将不同个体或样本分组的有效性的方法。

在判别分析中,我们希望通过已有的数据集,找到一种线性或非线性的方式将不同类别的样本区分开来。

判别分析通常用于以下几个方面:1. 分类问题:当我们面对一个具有多个类别的问题时,判别分析可以帮助我们将样本分到不同的类别中。

2. 数据降维:判别分析可以将高维度的数据降低到较低维度,从而使数据更加易于理解和处理。

3. 特征选择:通过判别分析,我们可以确定哪些特征(自变量)对于区分不同类别的样本最具有判别性。

二、判别分析的应用场景判别分析在实际生活和各个领域中都有广泛的应用,下面列举几个常见的应用场景。

1. 医学诊断:判别分析可以通过分析病人的生理指标(如血压、心率等)来帮助确定病人是否患有某种疾病。

2. 金融风险评估:通过判别分析,可以将客户分为高风险和低风险群体,从而帮助金融机构评估和管理风险。

3. 文本分类:在自然语言处理领域,判别分析可以通过分析文本的特征来将文本分为不同类别,如情感分类、垃圾邮件分类等。

4. 面部识别:判别分析可以通过分析不同人脸特征的差异性来进行人脸识别,应用广泛于安防领域和人工智能领域。

三、常见的判别分析方法在统计学中,有多种判别分析方法可供选择,下面介绍两种常见的方法。

1. 线性判别分析(Linear Discriminant Analysis,简称LDA):线性判别分析是一种常见且广泛使用的判别分析方法。

它通过将样本投影到低维空间来最大化类间的离散度,并最小化类内的离散度。

LDA假设不同类别的样本具有相同的协方差矩阵。

logit替代方法

logit替代方法逻辑斯蒂回归(Logistic Regression)是一种二分类的机器学习算法,主要用于预测一个事物属于其中一类的概率。

在一些情况下,我们可能需要找到替代Logit回归的方法。

下面将介绍几种常见的替代方法。

1. 线性判别分析(Linear Discriminant Analysis)线性判别分析是一种经典的分类方法,它试图找到一个线性判别函数,能够最大程度地将不同类别的样本分开。

和Logit回归一样,线性判别分析也是基于线性预测函数的。

它的一个优点是,当类别分布假设满足时,它可以通过最小化类别内离散度和最大化类别间距离的方式,得到一个最优的线性判别函数。

2. 支持向量机(Support Vector Machine)支持向量机是一种强大的分类器,它试图找到一个最优的超平面,将不同类别的样本分开。

支持向量机可以通过选择合适的核函数,将数据从低维映射到高维空间,从而使得在高维空间中是线性可分的。

相比Logit回归,支持向量机不仅可以处理线性可分的情况,还可以处理非线性可分的情况。

3. 决策树(Decision Tree)决策树是一种基于树结构的分类器,它通过一系列的二分判定,将样本逐步分成不同的类别。

决策树具有可解释性强的优点,它可以通过分支节点的判定条件,直观地解释分类的原因。

相对于Logit回归,决策树对于非线性关系的建模能力更强。

4. 随机森林(Random Forest)随机森林是基于决策树的一种集成学习方法,它通过构建多个决策树,并对它们的结果进行整合,从而提高了分类的准确性和鲁棒性。

相比于单个决策树,随机森林能够处理更复杂的分类问题,并且具有良好的抗噪能力。

5. 神经网络(Neural Network)神经网络是一种强大的机器学习模型,它模拟了生物神经元之间的连接和信息传递过程。

神经网络通过多个神经元层之间的连接,将输入映射到输出。

相比Logit回归,神经网络能够建模更复杂的非线性关系,并且具有更好的泛化能力。

linear discriminate analysis

linear discriminate analysis【实用版】目录1.线性判别分析的定义和基本概念2.线性判别分析的应用场景和问题解决能力3.线性判别分析的具体方法和步骤4.线性判别分析的优缺点和局限性5.线性判别分析的实际应用案例正文线性判别分析(Linear Discriminant Analysis,简称 LDA)是一种常用的监督学习方法,主要用于解决分类问题。

它是一种线性分类方法,通过找到一个最佳的线性分类器,将数据分为不同的类别。

LDA 基于数据分布的假设,即不同类别的数据具有不同的分布,通过最大化类内差异和最小化类间差异来实现分类。

LDA 的应用场景非常广泛,可以用于文本分类、图像分类、生物信息学、社会科学等领域。

在这些领域中,LDA 能够有效地解决分类问题,提高分类准确率。

例如,在文本分类中,LDA 可以通过分析词汇分布,将文本分为不同的主题或类别。

线性判别分析的具体方法和步骤如下:1.收集数据并计算数据矩阵。

2.计算数据矩阵的协方差矩阵和矩阵的特征值和特征向量。

3.根据特征值和特征向量构建线性分类器。

4.使用分类器对数据进行分类。

尽管 LDA 在分类问题上表现良好,但它也存在一些优缺点和局限性。

首先,LDA 要求数据矩阵的列向量是线性无关的,这可能会限制其在某些数据集上的表现。

其次,LDA 对数据中的噪声非常敏感,噪声的存在可能会对分类结果产生不良影响。

此外,LDA 是一种基于线性分类的方法,对于非线性分类问题可能无法有效解决。

尽管如此,LDA 在实际应用中仍然具有很高的价值。

例如,在文本分类中,LDA 可以有效地识别不同主题的文本,并为用户提供个性化的推荐。

在生物信息学中,LDA 可以用于基因表达数据的分类,以识别不同类型的细胞或疾病。

在社会科学中,LDA 可以用于对调查数据进行分类,以便更好地理解受访者的需求和偏好。

总之,线性判别分析是一种强大的分类方法,可以应用于各种领域。

线性判别分析算法在数据分类中的应用

线性判别分析算法在数据分类中的应用线性判别分析算法(Linear Discriminant Analysis, LDA)是一种常用的数据分类方法。

它的基本思想是通过将数据投影到一条直线(或者是高维空间中的一个超平面),使得同类之间的数据点尽可能接近,不同类之间的数据点尽可能远离。

这样,我们就可以用这条直线来区分不同的类别,从而实现数据分类的任务。

LDA算法的应用非常广泛,比如在机器学习、模式识别、图像处理、生物信息学等领域都有大量的应用。

下面,我们将从几个方面来介绍LDA算法在数据分类中的应用。

1. LDA算法在二分类问题中的应用二分类是指只涉及两个类别的分类问题。

LDA算法可以被用来解决二分类问题,特别是在数据样本有限的情况下,LDA算法表现得更加优秀。

LDA算法将数据样本投影到一条直线上,使得同类之间的数据点尽可能接近,不同类之间的数据点尽可能远离。

这样,我们可以通过比较投影后的数据点的位置来判断它属于哪个类别。

在实际应用中,我们可以通过LDA算法来处理一些二分类问题,如人脸识别、声音识别、图像分类等。

例如,在人脸识别中,我们可以将不同人的人脸图像看做不同的类别,通过LDA算法将它们投影到一条直线上,从而实现对不同人脸图像的识别。

2. LDA算法在多分类问题中的应用在许多实际问题中,涉及到的不止两个类别,而是多个类别。

LDA算法同样可以被用来解决多分类问题。

LDA算法在多分类问题中的应用稍有不同。

在二分类问题中,我们可以将数据点投影到一条直线上,但在多分类问题中,我们需要将数据点投影到更高维的空间中,即超平面上。

具体地,我们可以将每个类别看做一个投影方向,然后将所有的投影方向合并起来,形成一个超平面。

通过将数据样本投影到这个超平面上,我们可以将数据分类成多个类别。

3. LDA算法在降维问题中的应用在高维数据处理中,数据的维数通常会非常高。

这对数据处理带来了困难,因为高维数据不能直观地展示出来,也很难直接分析。

LDA线性判别分析报告

展开J(w)的分子并定义SB,SB称为Between-class scatter。 这样就得到了J(w)的最终表示:

上式求极大值可以利用拉格朗日乘数法,不过需要限定一下分母的值,否则分子分母

都变,怎么确定最好的w呢。可以令

,利用拉格朗日乘数法得到:

上式两边同乘以

可以得到:

发现w其实就是矩阵

的特征向量。

• LDA人脸识别(Fisherface)

通常情况下,待匹配人脸要和人脸库内的多张人脸匹配,所以这是一个多分类 的情况。出于简单考虑,可以先介绍二类的情况然后拓展到多类。假设有二维平面上 的两个点集x(x是包含横纵坐标的二维向量),它们的分布如下图(分别以蓝点和红 点表示数据):

以数学公式给出投影点到到原点的距离: w以从原点出发的直线来表示,直线上的点是原数据的投影点。下图给出了两种w 方案,直观判断右侧的w更好些,其上的投影点能够合理的区分原有的两个数据集。 但是计算机不知道这些,所以必须要有确定的方法来计算这个w。

首先计算每类数据的均值(中心点):

i是数据的分类个数,Ni代表某个分类下的数据点数,比如μ 1代表红点的中心,μ2代表蓝点的中心。

类均值点投影到w上的中心为: 如何判断向量w最佳?1、不同的分类得到的投影点要尽量分开;2、同一个分类投 影后得到的点要尽量聚合。从这两方面考虑,可以定义如下公式:

J(w)代表不同分类投影中心的距离,它的值越大越好。

2.确保这些变量是相互独立的

有效信息的提取综合及无用信息的摈弃。

3.提供一个框架来解释结果

降维标准:

投影后类内方差最小,类间方差最大。我们要将数据在低维度上进行投影, 投影后希望每一种类别数据的投影点尽可能的接近,而不同类别的数据的类别中心 之间的距离尽可能的大。

Fisher线性判别分析实验报告

Fisher 线性判别分析实验报告一、摘要Fisher 线性判别分析的基本思想:通过寻找一个投影方向(线性变换,线性组合),将高维问题降低到一维问题来解决,并且要求变换后的一维数据具有性质:同类样本尽可能聚集在一起,不同类样本尽可能地远。

Fisher 线性判别分析,就是通过给定的训练数据,确定投影方向w 和阈值y0,即确定线性判别函数,然后根据这个线性判别函数,对测试数据进行测试,得到测试数据的类别。

二、算法的基本原理及流程图1 基本原理 (1) W 的确定各类样本均值向量 mi样本类内离散度矩阵iS 和总类内离散度矩阵wS12wS S S =+样本类间离散度矩阵bS在投影后的一维空间中,各类样本均值 T i i m '= W m样本类内离散度和总类内离散度 T T i i w w S ' = W S W S ' = W S W样本类间离散度 T b b S ' = W S WFisher 准则函数满足两个性质:投影后,各类样本内部尽可能密集,即总类内离散度越小越好。

T x S (x m)(x m ), 1,2iiii X i ∈=--=∑T 1212S (m m )(m m )b =--投影后,各类样本尽可能离得远,即样本类间离散度越大越好。

根据这个性质确定准则函数,根据使准则函数取得最大值,可求出w -1W = S(m - m)w12(2)阈值的确定实验中采取的方法:y = (m' + m') / 2012(3) Fisher线性判别的决策规则对于某一个未知类别的样本向量 x,如果y = W T x >y0, 则x∈w1否则x∈w22流程图方差标准化 (归一化处理)一个样本集中,某一个特征的均值与方差为:归一化:1 男女同学身高体重,训练数据和测试数据都是50当采用StudentData1作为训练数据,StudnetData2作为测试数据时当采用StudnetData2作为训练数据,StudentData2作为测试数据时2IonoSphere数据考虑到第一组数据训练数据多,下面的实验以第一组数据的训练数据作为训练数据,分别用其他组的测试数据进行测试从实验结果看,Fisher线性判别用于两类的判别决策时,拥有不错的效果,并且当有足量的训练数据时,效果更好。