连续信源和波形信源

《信息论与编码技术》复习提纲复习题

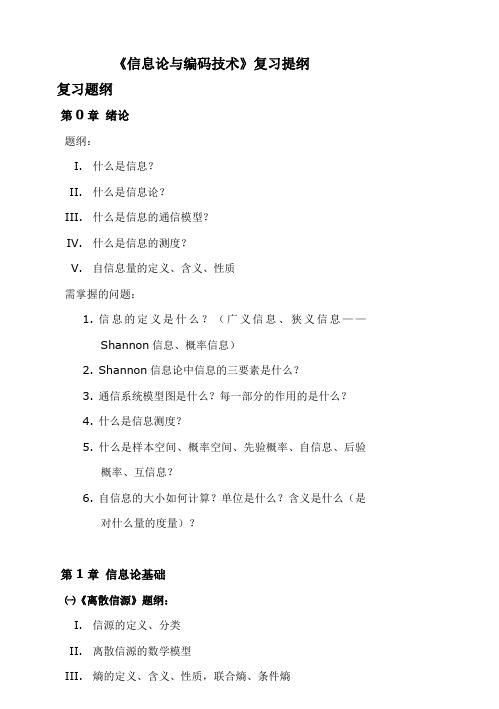

《信息论与编码技术》复习提纲复习题纲第0章绪论题纲:I.什么是信息?II.什么是信息论?III.什么是信息的通信模型?IV.什么是信息的测度?V.自信息量的定义、含义、性质需掌握的问题:1.信息的定义是什么?(广义信息、狭义信息——Shannon信息、概率信息)2.Shannon信息论中信息的三要素是什么?3.通信系统模型图是什么?每一部分的作用的是什么?4.什么是信息测度?5.什么是样本空间、概率空间、先验概率、自信息、后验概率、互信息?6.自信息的大小如何计算?单位是什么?含义是什么(是对什么量的度量)?第1章信息论基础㈠《离散信源》题纲:I.信源的定义、分类II.离散信源的数学模型III.熵的定义、含义、性质,联合熵、条件熵IV.离散无记忆信源的特性、熵V.离散有记忆信源的熵、平均符号熵、极限熵VI.马尔科夫信源的定义、状态转移图VII.信源的相对信息率和冗余度需掌握的问题:1.信源的定义、分类是什么?2.离散信源的数学模型是什么?3.信息熵的表达式是什么?信息熵的单位是什么?信息熵的含义是什么?信息熵的性质是什么?4.单符号离散信源最大熵是多少?信源概率如何分布时能达到?5.信源的码率和信息率是什么,如何计算?6.什么是离散无记忆信源?什么是离散有记忆信源?7.离散无记忆信源的数学模型如何描述?信息熵、平均符号熵如何计算?8.离散有记忆多符号离散平稳信源的平均符号熵、极限熵、条件熵(N阶熵)的计算、关系和性质是什么?9.什么是马尔科夫信源?马尔科夫信源的数学模型是什么?马尔科夫信源满足的2个条件是什么?10.马尔科夫信源的状态、状态转移是什么?如何绘制马尔科夫信源状态转移图?11.马尔科夫信源的稳态概率、稳态符号概率、稳态信息熵如何计算?12.信源的相对信息率和冗余度是什么?如何计算?㈡《离散信道》题纲:I.信道的数学模型及分类II.典型离散信道的数学模型III.先验熵和后验熵IV.互信息的定义、性质V.平均互信息的定义、含义、性质、维拉图VI.信道容量的定义VII.特殊离散信道的信道容量需掌握的问题:1.信道的定义是什么?信道如何分类?信道的数学模型是什么?2.二元对称信道和二元删除信道的信道传输概率矩阵是什么?3.对称信道的信道传输概率矩阵有什么特点?4.根据信道的转移特性图,写出信道传输概率矩阵。

信息论重点 (新)

1.消息定义信息的通俗概念:消息就是信息,用文字、符号、数据、语言、音符、图片、图像等能够被人们感觉器官所感知的形式,把客观物质运动和主观思维活动的状态表达出来,就成为消息,消息中包含信息,消息是信息的载体。

信号是表示消息的物理量,包括电信号、光信号等。

信号中携带着消息,信号是消息的载体。

信息的狭义概念(香农信息):信息是对事物运动状态或存在方式的不确定性的描述。

信息的广义概念 信息是认识主体(人、生物、机器)所感受的和表达的事物运动的状态和运动状态变化的方式。

➢ 语法信息(语法信息是指信息存在和运动的状态与方式。

) ➢ 语义信息(语义信息是指信宿接收和理解的信息的内容。

) ➢ 语用信息(语用信息是指信息内容对信宿的有用性。

)2.狭义信息论、广义信息论。

狭义信息论:信息论是在信息可以量度的基础上,对如何有效,可靠地传递信息进行研究的科学。

它涉及信息量度,信息特性,信息传输速率,信道容量,干扰对信息传输的影响等方面的知识。

广义信息论:信息是物质的普遍属性,所谓物质系统的信息是指它所属的物理系统在同一切其他物质系统全面相互作用(或联系)过程中,以质、能和波动的形式所呈现的结构、状态和历史。

包含通信的全部统计问题的研究,除了香农信息论之外,还包括信号设计,噪声理论,信号的检测与估值等。

3.自信息 互信息 定义 性质及物理意义 自信息量: ()log ()i x i I x P x =-是无量纲的,一般根据对数的底来定义单位:当对数底为2时,自信息量的单位为比特;对数底为e 时,其单位为奈特;对数底为10时,其单位为哈特自信息量性质:I(x i )是随机量;I(x i )是非负值;I(x i )是P(x i )的单调递减函数。

自信息物理意义: 1.事件发生前描述该事件发生的不确定性的大小 2.事件发生后表示该事件所含有(提供)的信息量 互信息量:互信息量的性质:1) 互信息的对称性2) 互信息可为零3) 互信息可为正值或负值4) 任何两个事件之间的互信息不可能大于其中任一事件的自信息互信息物理意义: 1.表示事件 yj 出现前后关于事件xi 的不确定性减少的量 2.事件 yj 出现以后信宿获得的关于事件 xi 的信息量4.平均自信息性质 平均互信息性质平均自信息(信息熵/信源熵/香农熵/无条件熵/熵函数/熵):(;)()(|)i j i i j I x y I x I x y =-log ()log (|)(1,2,,;1,2,,)i i jp x p x y i n j m =-+=⋯=⋯(|)log ()i j i p x y p x =1()[()][log ()]()log ()ni i i i i H X E I x E p x p x p x ===-=-∑熵函数的数学特性包括:(1)对称性 p =(p1p2…pn)各分量次序可调换 (2)确定性p 中只要有为1的分量,H(p )为0(3)非负性离散信源的熵满足非负性,而连续信源的熵可能为负。

信息论与编码[第二章离散信源及其信息测度]山东大学期末考试知识点复习

![信息论与编码[第二章离散信源及其信息测度]山东大学期末考试知识点复习](https://img.taocdn.com/s3/m/4f9eb902763231126edb115f.png)

第二章离散信源及其信息测度2.1.1 信源的分类信源是信息的来源,是产生消息或消息序列的源泉。

不同的信源输出的消息其随机性质不同。

根据消息所具有的随机性质的不同,对信源进行如下分类:按照消息取值集合以及取值时刻集合的离散性和连续性,信源可分为离散信源(数字信源)和波形信源(模拟信源);按照某取值时刻消息的取值集合的离散性和连续性,信源可分为离散信源和连续信源;按照信源输出消息所对应的随机序列的平稳性,信源可分为平稳信源和非平稳信源;按照信源输出的信息所对应的随机序列中随机变量前后之间有无统计依赖关系,信源可分为无记忆信源和有记忆信源。

2.1.2 基本信源的数学模型根据信源输出消息所对应的不同的随机特性就有不同的信源数学模型。

而基本的信源数学模型有以下几种。

1.离散信源信源输出的是单个符号或代码的消息,信源符号集的取值是有限的,或可数的,可以用一维离散型随机变量来描述。

信源的数学模型就是离散型随机变量x的概率空间,表示为2.连续信源信源输出的是单个符号或代码的消息,但信源符号集的取值是连续的,可以用一维连续型随机变量来描述。

相应的信源的数学模型就是连续型随机变量的概率空间,表示为其中(a,b)是连续随机变量X的取值区间,R表示全实数集,而p(x)是连续随机变量X的概率密度函数。

2.1.3 离散信源的信息熵1.自信息自信息即为某事件a i发生所含有的信息量。

事件的自信息定义为式中P(a i)是事件a i发生的概率。

自信息的单位有几种:以2为底的对数时单位是比特(bit);以e为底的自然对数时单位是奈特(nat);以10为底的常用对数时单位是哈特(hart)。

2.信息熵离散随机变量X的信息熵就是其概率空间中每个事件所含有的自信息量的数学期望,即其单位是:以2为底的对数时是比特/符号(bit/symbol);以e为底的对数时是奈特/符号(nat/symbol);以10为底的对数时是哈特/符号(hart/symbol)。

第四章 波形信源和波形信道

2

-2 F 2 F 其他

其自相关函数

Rn

(

)

1

2

Pn

()e

j

d

N0

F

sin(2 F 2 F

)

由功率谱密度可知在时间间隔 1的两个样本点之间的相

2F

关函数等于零,

所以各样本值之间不相关。有因为随即变量是高斯概率

密度分布的,所以随机变量之间统计独立。

第四节 连续信道和波形信道的分类

4.有色噪声信道 除白噪声以外的噪声称为有色噪声。信道的噪声是

率是按正、负两半轴上的频谱定义的。只采用正半轴频谱来

定义,则功率谱为

N

,常称为单边谱密度。而

0

N0 /称2 为双

边谱密度,单位为瓦/赫(W/Hz)。显然。白噪声的相关函数

是 函数:

Pn ()

N0 2

Rn ( )

N0 2

( )

第四节 连续信道和波形信道的分类

3.高斯白噪声信道

具有高斯分布的白噪声称为高斯白噪声。一般情况把既服 从高斯分布而功率谱密度又是均匀的噪声称为高斯白噪声。 关于低频限带高斯白噪声有一个很重要的性质,即低频限带 高斯白噪声经过取样函数取值后可分解成N(=2FT)个统计 独立的高斯随机变量(方差为 N0 / ,2 均值也为零)。

且当随机序列中各变量统计独立时等式成立。

第二节 波形信源和波形信源的信息测度

两种特殊连续信源的差熵

1.均匀分布连续信源的熵值

一维连续随机变量X在[a,b]区间内均匀分布时,这基本连

续信源的熵为 h( X ) log(b a)

N维连续平稳信源,若其输出N维矢量 X ( X1X 2 X N )

其分量分别在 [a1, b2 ], ,[aN , bN ] 的区域内均匀分布,

北邮-田宝玉-信息论基础-第一章

仙农在1948年指出 :

“ 通信的基本问题是在一点精确地或近似地恢复 另一点所选择的消息。通常,这些消息是有含义 的,即它对于某系统指的是某些物理的或概念的 实体。这些通信的语义方面与通信问题无关,而

重要的方面是实际消息是从一个可能消息集合中

选择出的一条消息。”

可见,仙农在研究信息理论时,排除了语义 信息与语用信息的因素,先从语法信息入手,解 决当时最重要的通信工程一类的信息传递问题。 同时他还把信源看成具有输出的随机过程,所研 究的事物运动状态和变化方式的外在形式遵循某 种概率分布。因此仙农信息论或经典信息论所研 究的信息是语法信息中的概率信息。

信 息 论 即 仙 农 (Claude Edwood Shannon, 1916—2001 ) 信 息 论 , 也 称 经 典信息论,是研究通信系统极限性能的理 论。从信息论产生到现在几十年来,随着 人们对信息的认识不断深化,对信息论的 研究日益广泛和深入,信息论的基本思想 和方法已经渗透到许多学科,在人类社会 已经进入信息时代的今天,信息理论在自 然科学和社会科学研究领域还会发挥更大 的作用。

第一层:通信符号如何精确传输?(技术问题) 第二层:传输的符号如何精确携带所需要的含义? (语义问题) 第三层:所接收的含义如何以所需要的方式有效地 影响行为?(效用问题)

• Weaver认为仙农的工作属于第一层,但他又证明 仙农的工作是交叉的,对第二、三层也有意义。

• 信息是认识主体(人、生物、机器) 所感受的和 所表达的事物运动的状态和运动状态变化的方式。

可见,信息收集组是根据所得到的消 息提取出语法信息,信息处理组是根据所 得到的语法信息提取出语义信息,而信息 分析组是根据所得到的语义信息提取出语 用信息。 可以看到,研究语义信息要以语法信 息为基础,研究语用信息要以语义信息和 语法信息为基础。三者之间,语法信息是 最简单、最基本的层次,语用信息则是最 复杂、最实用的层次。

课程教学大纲-信息工程学院

《信息论与编码》课程教学大纲一、课程名称1.中文名称:信息论与编码2.英文名称:Information Theory and Coding二、课程概况课程类别:专业选修课学时数:36学分数:2适用专业:通信工程、电子信息工程等专业开课学期:第一学期开课单位:信息工程学院电子信息工程系三、大纲编写人:张露四、教学目的及要求•教学目的:通过本课程向学生介绍信息科学的基础理论和基本方法,使学生掌握信息理论的基础和编码理论。

•教学要求:掌握信息论的基本原理、编码理论和实现方法,主要包括:绪论、离散信源及其信息测度、离散信道及其信道容量、无失真信源编码、有噪信道编码、波形信源和波形信道。

本课程以概率论为基础,数学推导较多,教学时主要关注学生对概念的理解,不过分追求数学细节的推导。

注意帮助学生理解各个概念的含义和作用,结合其他课程理解它的意义。

注重培养学生的独立思考能力。

五、课程主要内容及先修课程•主要内容:1)绪论: 信息的概念,信息论研究的对象、目的和内容,信息论的发展简史与现状2)离散信源及其信息测度:信息的数学模型及分类,离散信源的信息熵,信息熵的基本性质,离散无记忆的扩展信源,离散平衡信源,马尔可夫信源,信息冗余度与自然语言的熵3)离散信道及其信道容量:信道的数学模型及分类,平均互信息,平均互信息的特性,信道容量及其一般计算方法,离散无记忆扩展信道及其信道容量,信源与信道的匹配4)无失真信源编码:码的分类,等长信源编码定理,变长信源编码定理,香农编码,费诺编码,霍夫曼编码,游程编码、算术编码、冗长编码5)有噪信道编码:错误概率与译码规则,错误概率与编码方法,有噪信道编码定理,联合信源信道编码定理,纠错编码的基本思想,常用编码方法6)波形信源和波形信道:波形信源的统计特性和离散化,连续信源和信源的信息测度,具有最大熵的连续信源,连续信道和波形信道的分类,连续信道和波形信道的信息传输率,连续信道和波形信道的信道容量,连续信道编码定理•先修课程《概率论》和《通信原理》六、课程教学方法《信息论与编码》理论性较强,授课时应根据学生的基础,采用PPT和板书推导相结合的教学方式。

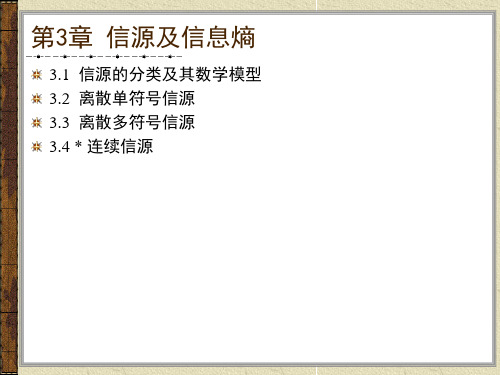

信息论第3章信源及信息熵

举例

数学描述

离散信源 (数字信源)

连续信号

文字、数据、 离散化图象

离散随机变量 序列

跳远比赛的结果、语音 连续随机变量

信号抽样以后

序列

波形信源 (模拟信源)

语音、音乐、热噪声、 图形、图象

不常见

随机过程

表3.1 信源的分类

3.1 信源的分类及其数学模型

我们还可以根据各维随机变量的概率分布是否随时间的推移 而变化将信源分为平稳信源和非平稳信源,根据随机变量间 是否统计独立将信源分为有记忆信源和无记忆信源。

定义3.2 随机变量序列中,对前N个随机变量的联合熵求平

均:

HN

(X)

1 N

H ( X1X 2

XN)

称为平均符号熵。如果当N

时上式极限存在,则

lim

N

H

N

(X)

称为熵率,或称为极限熵,记为

def

H

lim

N

H

N

(

X

)

3.3.1 离散平稳无记忆信源

离散平稳无记忆信源输出的符号序列是平稳随机序列,并且

H(X ) H(X1X2 XN ) H ( X1) H ( X2 | X1) H ( X3 | X1X 2 ) H ( X N | X1X 2 X N1)

定理3.1 对于离散平稳信源,有以下几个结论:

(1)条件熵 H (X N | X1X 2 X N1) 随N的增加是递减的;

(2)N给定时平均符号熵大于等于条件熵,即

s1

si p(s j

| si )

s q

m

状态空间由所有状态及状态间的状态转移概率组成。通过引

入状态转移概率,可以将对马尔可夫信源的研究转化为对马 尔可夫链的研究。

普通高等教育 电子信息工程专业教学大纲合集 1041812信息论与编码课程教学大纲

《信息论与编码》教学大纲课程编码:1041812课程性质:专业课程适用专业:电子信息工程学分:2学分学时:36学时开设学期:第5学期一、教学目的本课程的教学目的是使学生掌握信息处理的理论基础和各种编码原理、手段与方法。

培养学生能够适应数字通信、信息处理、信息安全、计算机信息管理等编码工作的要求。

使学生掌握信息理论的基本概念和信息分析方法及主要结论,为今后从事信息领域的科研及工程工作的进一步研究打下坚实的理论基础。

二、教学重点与难点1.重点:信息以及失真的测度、信道及信道容量、无失真信源编码方法以及有噪信道编码方法。

2.难点: 典型序列以及由此推导出的香农三大编码定理及其逆定理。

三、教学方法建议讲授法:教师讲授信息论与编码的基本知识和研究现状。

讨论法:师生共同讨论信息论与编码中研究的问题。

探究法:师生共同探究信息论与编码中前沿问题。

四、教学内容第一章信息理论基础(4学时)教学要求:了解信息论研究对象、目的、发展简史与现状;了解通信系统的模型以及通信系统各部分的主要组成以及作用。

1.信息论的形成和发展2.通信系统的模型3.信息论研究的内容第二章离散信源及其测度(8学时)教学要求:了解信源的相关性和剩余度的概念,消息、信息、信号的概念,信息,信号,消息,数据的关系及其联系。

掌握信源的数学模型、离散无记忆信源、离散平稳信源和马尔可夫信源基本理论。

1.信源的数学模型及分类2.信息熵及其基本性质3.离散平稳信源4.马尔可夫信源5.信息剩余度第三章离散信道及其信道容量(8学时)教学要求:了解一般信道容量的计算方法。

掌握信道的数学模型,离散无记忆信道以及一些特殊信道容量的计算方法。

1.信道数学模型及分类2.平均互信息及特点3.信道容量及一般计算方法4.离散无记忆扩展信道及其容量第四章无失真信源编码(8学时)教学要求:了解其它一些无失真信源编码方法;理解渐近等分割性及ε典型序列,算术编码方法及具体实现方案;掌握编码的定义、码的分类、定长编码定理、变长编码定理、最佳编码方法、香农编码方法、费诺编码方法、哈夫曼编码方法。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

第7章 连续信源和波形信源主要内容◆ 连续/波形信源的统计特性 ◆ 连续/波形信源的信息度量 ◆ 连续信源的信息率失真函数7.1 连续/波形信源的统计特性图7.1 一个随机过程{}()x t111212121212()()()n n n p x t p x x t t p x x x t t t ⎧⎪⎪⎨⎪⎪⎩ ,,,,,,,,,,, 12121212()()12n n n n n n p x x x t t t p x x x t t t n τττ=+++=,,,,,,,,,,,,,,,,sin π(2)()2π(2)n n Ft n f t f F Ft n ∞=-∞-⎛⎫=⎪-⎝⎭∑12f F ⎛⎫⎪⎝⎭,信息论基础及应用21622f F ⎛⎫ ⎪⎝⎭, 12F∆=7.2 连续信源和波形信源的信息度量7.2.1 连续信源的差熵d ()()d X F x p x x=d ()()d Y F y p y y =111()[]()d x X F x p X x p x x -∞==⎰≤//(/)(/)Y X X Y p y x p x y2111111()()XY F x y p x y x y ∂=∂∂,//()()(/)()(/)XY X Y X Y X Y p xy p x p y x p y p x y ==()()d X Y Rp x p xy y =⎰ ()()d Y X Rp y p xy x =⎰⎥⎥⎦⎤⎢⎢⎣⎡=)(x p R X 并满足()d 1Rp x x =⎰(1){(1)}()d ()(12)i a i i a i p p a i x a i p x x p x i n ∆∆∆∆∆++-=+-+===⎰≤≤,,,1212()()()n n n X x x x p x p x p x P ∆∆∆⎡⎤⎡⎤=⎢⎥⎢⎥⎣⎦⎣⎦图7.2 概率密度分布第7章 连续信源和波形信源217(1)11()()d ()d 1n na i Δbi a i Δai i p x p x x p x x ∆++-=====∑∑⎰⎰()log ()log[()]()log ()()log n i i i i iii i i iiH X p p p x p x p x p x p x ∆∆∆∆∆=-=-=--∑∑∑∑()lim ()lim ()log ()lim(log )()()log ()d limlog n i i i n ibaH X H X p x p x p x p x p x x ∆∆∆∆∆→∞∆→∆→→==--=--∑∑⎰()()log ()d Rh X p x p x x =-⎰()()log ()d d (/)()(/)log (/)d d (/)()(/)log (/)d d RRRh XY p xy p xy x yh Y X p x p y x p y x x y h X Y p y p x y p x y x y=-=-=-⎰⎰⎰⎰⎰⎰()()(/)()(/)h XY h X h Y X h Y h X Y =+=+(/)()h X Y h X ≤或(/)()h Y X h Y ≤()()()h XY h X h Y +≤1()0a x b p x b ax b x a ⎧⎪=-⎨⎪><⎩≤≤, 11()log d log()b a h X x b a b a b a=-=---⎰πcos ||()2A x x p x x ⎧⎪=⎨⎪⎩≤取其他值信息论基础及应用218()[][][]π2π2ππ22ππ22π2π2π2π2ππ22ππ22cos ln cos d ln cos d cos ln cos d 2ln 2ln ln(1sin )(1sin )dsin 22ln ln(1sin )d(1sin )ln(1sin )d(1sin )222ln h X A x A x xA A x x A x x x A A A x A A A x x xA A A A x x x x A -------=-=--=--=---+=-+---++=-⎰⎰⎰⎰⎰⎰⎰2ln 22A A A-+π2π2()d 1p x x -=⎰12=A 即21=A ()1h X =奈特/自由度 ()()()I X Y h X h Y =-;222222()()()()1()2(1)x y y x x x y y x m y m y m x m p xy ρρδδδδ⎧⎫⎡⎤----⎪⎪=--+⎢⎥⎨⎬-⎢⎥⎪⎪⎣⎦⎩⎭221()()d ()2x x x p x p xy y x m δ∞-∞⎧⎫=--⎨⎬⎩⎭⎰()()log ()d )x h X p x p x x ∞-∞=-=⎰()()log ()d )y h Y p y p y y ∞-∞=-=⎰222222222222(/)()log (/)d d 2()()()1()2(1)(1)()() log e d d (1)log e 1212111x y x x x y y y y y h X Y p xy p x y x yx m y m x m p xy y m y m x yρρδρδδρδδρρρρ∞∞-∞-∞∞∞-∞-∞=-⎧⎡---⎪=-⎢⎨--⎢⎪⎣⎩⎫⎤--⎪+-⎥⎬-⎥⎪⎦⎭=-+---⎰⎰⎰⎰21⎛⎫- ⎪⎝⎭=()/h Y X =第7章 连续信源和波形信源2192222222()()log ()d d 2()()()1()log 2π2(1)(1)() log e d d (1)x y x x x x y y y h XY p xy p xy x yx m y m x m p xy y m x yρδδρδρδδρδ∞∞-∞-∞∞∞-∞-∞=-⎧⎡---⎪⎡=+-⎢⎨⎣--⎢⎪⎣⎩⎫⎤-⎪+⎥⎬-⎥⎪⎦⎭⎰⎰⎰⎰2222log e 121log 2π2111log 2πe x x ρδδρρρδδ⎛⎫⎡=+-+ ⎪⎣---⎝⎭⎡=⎣()()(/)I X Y h X h X Y =-==-;7.2.2 波形信源的差熵1212()()N N p p x x x y y y xy =1212111211112111()d d d d 1()()()d d ()()()d d ()(/)()()(/)()NN N N RN N N NRN N N N Rp x x xy y y x x y y p x p x x x p x x y y y y p y p y y y p x x y y x x p xy p y x p x p xy p x y p y =======⎰⎰⎰⎰⎰⎰1212112()()()log ()d ()()()log ()d (/)(/)()log (/)d d N RN RN N Rh X h X X X p x p x xh Y h YY Y p y p y y h Y X h Y Y X X X p p y x x yxy ==-==-==-⎰⎰⎰⎰11(/)(/)()log (/)d d N N Rh X Y h X X Y Y p p x y x yxy ==-⎰⎰()()(/)()(/)I X Y h X h X Y h Y h Y X =-=- ;(())lim ()N h x t h X →∞∆(())lim ()N h y t h Y →∞∆信息论基础及应用220(()/())lim (/)N h y t x t h Y X →∞∆(()/())lim (/)N h x t y t h X Y →∞∆(()())lim ()N I x t y t I X Y →∞∆;;12121312121()()()(/)(/)(/)N N N h X h X X X h X H X X h X X X h X X X X -==++++1212()()()()()N N h X h X X X h X h X h X =+++≤7.2.3 三种特殊连续信源的差熵)log()(a b X h -= 比特/自由度1111()()()0()Ni i Ni i i i N i i i x b a b a p x x b a ===⎧∈-⎪⎪-⎪=⎨⎪⎪∈-⎪⎩∏∏∏ 121()()()NN i i p x p x x x p x ===∏111112111()()log ()d 11logd d d ()()log () /N NN Nb b a a b b N NNa a iiiii i Ni i i h X p x p x xx x x b a b a b a N ====-=---=-⎰⎰⎰⎰∏∏∏ 比特自由度1()log ()2log()N i i i h X b a FT b a ==-=-∏)log(2)(a b F X h t -= 1e 0()00xa x ap x x -⎧>⎪=⎨⎪⎩≤1[]e d xa m E X x x a a-∞===⎰第7章 连续信源和波形信源22102002211()()log ()d e log e d 11log e d e d 11log log 1x xa a x x a a h X p x p x x xaa a x x xa a a a a a a a--∞∞--∞∞⎡⎤⎡⎤=-=-⎢⎥⎢⎥⎣⎦⎣⎦=⋅+=⋅+⋅=+⎰⎰⎰⎰22()()2x m p x σ⎛⎫-=- ⎪⎝⎭(22222()()log ()d ()()log d 2()()d ()d log e 21log e21log 2πe 2h X p x p x xx m p x x x m p x x p x x σσσ∞-∞∞-∞∞∞-∞-∞=-⎡⎤⎛⎫-=--⎥ ⎪⎝⎭⎦⎡⎤-=--+⋅⎢⎥⎣⎦==⎰⎰⎰⎰ ()d 1p x x ∞-∞=⎰和22()()d x m p x x σ∞-∞-=⎰。

1()log2πe 2h X P =N j i m X m X E j j i i ij ,,,, 21)])([(=--=μ111212122212N N N N NN R μμμμμμμμμ⎡⎤⎢⎥⎢⎥=⎢⎥⎢⎥⎣⎦1/21/21111()exp ||()()(2π)||2||N N ij i i j j i j p x R x m x m R R ==⎡⎤=---⎢⎥⎣⎦∑∑ 1/21/211/21/2/21/2()()log ()d 11()log exp ||()()d d (2π)||2||log(2π)||log e2log[(2πe)||]1log(2πe)||2N N ij i i j j N N R i j N N N h X p x p x x p x R x m x m x x R R NR R R ∞-∞===-⎫⎤⎧⎡⎪=--⨯--⎨⎬⎥⎢⎣⎪⎩⎦⎭=+=⋅=⎰∑∑⎰⎰ 21||Ni i R σ==∏信息论基础及应用2222221/121()log 2πe()()2N NN i i N h X h X σσσ===∑7.3 最大差熵定理122()d 1()d ()()d p x x xp x x K x m p x x K ∞-∞∞-∞∞-∞==-=⎰⎰⎰求泛函数()()log ()d h X p x p x x ∞-∞=-⎰的极值。