10.4最小二乘优化问题

最小二乘优化算法

最小二乘优化算法最小二乘优化算法是数据拟合中使用的一种经典算法,其主要思路是通过最小化残差平方和,找到最佳的拟合函数,使得拟合函数与实际数据点的误差最小。

在实际应用中,最小二乘优化算法广泛应用于曲线拟合、参数估计、数据降噪等领域。

该算法具有计算简单、稳定性好、误差分析清晰等优点,在许多领域中取得了重要的应用价值。

最小二乘优化算法的基本思路可以用简单的线性模型来解释。

假设有一组数据点(x1,y1),(x2,y2)...(xn,yn),要拟合一个线性模型y = ax + b,使得拟合函数与实际数据点的误差最小。

最小二乘优化算法就是通过最小化残差平方和来寻找最优解。

残差平方和的定义是:其中,f(xi)代表拟合函数的值。

求解最小二乘问题的一般步骤如下:1.建立线性模型根据具体问题建立线性模型,确定拟合函数的形式。

在实际应用中,线性模型不一定是简单的直线,也可以是高阶多项式、指数函数、对数函数等。

2.建立目标函数以残差平方和为目标函数,即:3.求解目标函数的最小值最小二乘问题的求解可以采用多种方法,其中最常见的方法是矩阵求导法。

该方法通过求解目标函数的一阶导数和二阶导数,来确定目标函数的最小值点。

4.进行误差分析最小二乘拟合结果不仅仅是一个拟合函数,还有对拟合数据的误差分析。

通过残差分析和方差分析等方法,可以评估拟合函数的精度和信任度。

最小二乘优化算法的应用非常广泛,包括信号处理、统计回归、机器学习、人工智能等领域。

在现代数据科学中,最小二乘拟合算法是数据建模和模型验证中最基本、最常用的算法之一。

总的来说,最小二乘优化算法是一种十分重要的数学工具,可以在很多领域中使用。

通过这种算法可以更好地拟合数据,并得到较为准确的结果,帮助人们更好地应对不同的问题和挑战。

工程优化 4-最小二乘法

g ( x ) f ( x ) 2 ri ( x )ri ( x ) 2J ( x )T r ( x )

i 1

m

其中

r1 x ... 1 J ( x) rm ... x1 f ( x )的 Hessian 矩阵为

m i 1 T

r1 x n 称为 r ( x )的 Jacobi 矩阵 rm x n

T 2 xE

m

,rm ( x )) ,x E n 其中r ( x ) (r1 ( x ),r2 ( x ),

i 1 T

如果 r ( x )是线性函数,则称 是x的非线性函数。 问题 ( P )是线性最小二乘问题。

求解最小二乘问题等价于求解方程组: ri ( x ) 0 i 1,2,, m 最小二乘问题在数据拟合,参数估计和函数逼近 等方面有广泛的应用。

* 2 2

[ ( Ax * b ) A ]T [ ( Ax * b ) A ] Ax b A 2 T AT ( Ax * b )

* 2 2

Ax b A 2 T ( AT Ax * AT b )

*

2

2

Ax b A

*

*

由于牛顿法在标准假设下是局部二阶收敛的,因 此, Gauss-Newton 法的成功将依赖于所忽略的 G(x)中的二阶信息项S(x)在G(x)中的重要性。 可以证明: 如果S(x*)=0, 则Gauss-Newton 法也是 二阶收敛的。 如果S(x*)相对于J(x*)T J(x*) 是小的,则 Gauss-Newton 法是局部Q线性收敛的。 如果S(x*)太大,则Gauss-Newton 法可 能不收敛。

2

最小二乘修正算法

Y Xθ ε

T T T

——————④

于是得:

θ ( X) Y ( X) ε

T T T T

1

1

———⑤ ———⑥

取上式等号右边第一项作为θ的估计量,记为

ˆ (T X) 1 T Y θ IV

式中,Ω称为辅助变量矩阵,Ω中的元素称为辅助变量。

式⑥在形式上与一般最小二乘估计公式相似,但 它在{ε(k)}为有色噪声情况下是参数的一致无偏估计量。 这是因为式⑤有

ˆ

IV

( X)

T 1 T

———⑦

利用滤波法的出发点是:如果辅助模型是未 受噪声ξ(k)干扰的原系统模型,那么辅助模型的 输出就是v(k),且满足: 1 显然,由{v(k)},{u(k)}构成的下列辅助矩 阵

T (n 1) v(n) v(1) u ( n) u (1) T (n N ) v(n N 1) v( N ) u (n N 1) u ( N )

B(q ) v(k ) u ε无关而与X相关,因此②,③式 必满足。

但被辨对象的理想输出yu(k)得不到,因此只能利 ˆ ˆ 用被辨系统的一个拟合模型 B(q 1 ) / A(q 1 ) 代替 B(q1 )/ A(q1 ) ,并利用这个辅助模型的输出来代替v(k)。 ˆ (q 1 ) 显然,辅助模型的输出应为v(k ) B ˆ u (k ) 1 ˆ A(q ) 而辅助变量矩阵相应为

A(q 1 ) y(k ) B(q 1 )u(k ) (k )

其向量形式为:

Y X

————①

• 式中

xT (n 1) y (n 1) (n 1) , ε , X Y xT ( n N ) y (n N ) (n N )

最小二乘问题公式(一)

最小二乘问题公式(一)最小二乘问题公式1. 最小二乘问题简介最小二乘问题是一种统计学和数学中常见的优化问题。

它的目标是求解一个线性模型,使得模型中的实际观测值与模型预测值之间的残差的平方和最小。

2. 最小二乘问题公式最小二乘问题的公式可以表示为:∥Ax−b∥2minx其中,A是一个m×n的矩阵,x是一个n维列向量,b是一个m维列向量。

3. 相关公式下面列举一些与最小二乘问题相关的公式:正规方程最小二乘问题的解可以通过使用正规方程求解:x=(A T A)−1A T b这里,A T表示A的转置,A−1表示A的逆矩阵。

最小二乘解的闭式解对于线性模型 Ax =b ,当 A T A 是满秩矩阵时,最小二乘问题的解存在唯一的闭式解。

QR 分解法除了使用正规方程,还可以使用QR 分解法求解最小二乘问题。

使用QR 分解可以将最小二乘问题转化为一个更容易求解的等价问题。

广义逆矩阵最小二乘问题的解可以通过求解广义逆矩阵的方式得到:x =A †b这里,A † 是矩阵 A 的广义逆矩阵。

4. 示例解释假设有一组观测数据,其中 m =5 表示观测样本数量,n =2 表示模型参数数量。

我们可以将这些观测数据表示为矩阵 A 和列向量 b 。

通过求解最小二乘问题,可以得到模型的最优参数估计。

假设观测数据的矩阵表示为:A =[ 12345678910]观测数据的目标值列向量表示为:b=[3 7 11 15 19]根据最小二乘问题的公式,我们可以求解最优参数估计:x=(A T A)−1A T b带入具体数值计算后,得到最优参数估计为:x=[11]这表示线性模型的最优参数为x1=1和x2=1。

5. 总结最小二乘问题是一种常见的优化问题,用于求解线性模型的最优参数估计。

通过求解最小二乘问题的公式,可以得到模型的最优参数估计。

正规方程、闭式解、QR分解法和广义逆矩阵都是常用的求解最小二乘问题的方法。

最小二乘拟合 梯度下降法

最小二乘拟合梯度下降法最小二乘法(Least Squares Method)和梯度下降法(Gradient Descent)都是求解优化问题的常用方法,可以应用于回归分析、数值逼近、机器学习等领域。

这两种方法都通过寻找一组数据的最佳拟合线来最小化误差。

一、最小二乘法最小二乘法是一种数学优化技术,通过最小化平方差或误差来找到最佳拟合线。

具体步骤如下:1. 确定目标函数:目标函数是数据点到拟合线的距离的平方和。

2. 构造矩阵:根据目标函数和数据点,构造相关矩阵。

3. 求解:通过解线性方程组,得到拟合线的系数。

最小二乘法的优点是简单易行,缺点是可能存在多个解,且对初始值选择敏感。

二、梯度下降法梯度下降法是一种基于函数梯度的下降方法,用于求解函数的最小值。

具体步骤如下:1. 初始化:选择一个初始猜测点,通常为零点或远离最优解的位置。

2. 计算梯度:根据目标函数和当前点,计算函数在该点的梯度。

3. 更新:根据梯度和学习率,更新当前点向拟合线的方向移动。

4. 重复:重复步骤2和3,直到达到停止条件(如达到最大迭代次数或找到足够接近最优解的点)。

梯度下降法的优点是稳定收敛,对初始值选择不敏感,适合处理多峰或多维度的优化问题。

缺点是可能存在多个局部最优解,需要选择合适的停止条件和初始点。

应用最小二乘法和梯度下降法进行数据拟合时,需要注意以下几点:1. 选择合适的拟合模型:根据数据的特点和问题需求,选择合适的拟合模型(线性、多项式、非线性等)。

2. 合理选择参数和超参数:在模型训练过程中,需要合理选择参数和超参数,如学习率、迭代次数、正则化等。

3. 评估模型性能:使用适当的评估指标(如均方误差、R-squared值、AUC 等)来评估模型的性能,并根据评估结果进行调整和优化。

总之,最小二乘法和梯度下降法都是求解优化问题的有效方法,可以根据具体问题选择合适的方法和参数进行拟合。

双变量最小二乘问题

双变量最小二乘问题是一个在统计学和回归分析中常见的问题。

它的目标是通过最小化预测变量和实际观测值之间的平方差和,来找到最佳的线性回归模型参数。

假设我们有一个数据集,其中包含两个预测变量(X_1) 和

(X_2),以及一个响应变量(Y)。

我们的目标是找到最佳的线性回归模型参数,使得(Y) 与(X_1) 和(X_2) 的预测值之间的平方误差最小。

数学上,双变量最小二乘问题可以表示为以下优化问题:

(\min_{b_0, b_1, b_2} \sum_{i=1}^{n} (Y_i - (b_0 + b_1 X_{1i} + b_2 X_{2i}))^2)其中(n) 是样本数量,(b_0, b_1, b_2) 是线性回归模型的参数。

为了解决这个问题,我们可以使用最小二乘法的解法,通过计算样本矩阵的伪逆或使用其他优化算法(如梯度下降法)来找到最优解。

在Python中,我们可以使用NumPy库中的线性代数函数或Scikit-learn库中的线性回归模型来解决这个问题。

下面是一个使用Scikit-learn库的示例代码:

输出结果为:

最佳参数:[1. 1.]

这意味着最佳的线性回归模型参数为(b_0 = 1.0, b_1 = 1.0, b_2 = 0)。

第五章--最小二乘问题的解法

第五章 最小二乘问题的解法1.最小二乘问题 1)回归方程问题[]Ti i l i yt t)()()(1,,...,,m i ,...,2,1=是m 个实验点。

现要根据这些点确定y 与l 个物理量l t t t ,...,,21之间的关系式。

设这种关系式为),...,,,...,(11n l x x t t F y =,其中n x x ,...,1是方程中需要待定的n 个参数(系数)。

因此问题是如何通过)(n m m >个实验点,确定方程中的系数。

由于实验点的个数大于待定系数的个数,因此方程中系数的确定是一个超静定问题,无法按一般的方法进行求解。

此时将实验点到曲面距离最短的那个曲面作为所求曲面,从而求取该曲面方程。

即求解[]∑=-mi i i y x t F 12)()(),(min ,这就是最小二乘问题。

2)非线性方程组问题求解非线性方程组⎪⎪⎩⎪⎪⎨⎧===0),...,(. 0),...,(0),...,(11211n n n n x x f x x f x x f 可转化为求解如下形式的最小二乘问题。

∑=mi n i x x f 112),...,(min显而易见,最小二乘法的一般形式可写为)()(minx f x f T最小二乘法问题实际上是具有n 个变量的无约束极小化问题,前面解无约束优化问题的方法均可应用。

但是最小二乘问题具有一定的特殊性,即目标函数的表达式是由多个表达式的平方和组成,理应有更、更有效的方法。

这正是最小二乘解法要解决的问题。

2.线性最小二乘问题的解法最小二乘法的一般形式可写为)()(min x f x f T特别地,当b Ax x f -=)(,即)(x f 为线性函数时,则最小二乘问题可表示为:2min bAx -1) 线性最小二乘问题解的条件定理1:*x 是线性最小二乘问题极小点的充要条件是*x 满足b A Ax A TT =。

证明:(1)必要性 令2)(bAx x s -=,于是有:bb Ax b b A x Ax A x b Ax b A x b Ax b Ax x s TTTTTTTTTT+--=--=--=))(()()()(由于b A x T T 是一个数,而一个数的转置是它的本身,因此有:Axb A x b b A x b A x TTT T T TTTTT===)()(故上式可化为:bb Ax b Ax A x x s TTTT+-=2)(b A Ax A x s TT22)(-=∇若*x 是)(x s 的极小点,则必有0)(=∇x s ,则必有:b A Ax A TT =(2)充分性 若*x 满足bA Ax A TT =*,即0)(*=-b Ax A T考虑任一点n R z x v ∈+=*,计算)(2)()()()()()())(())(()(*22*******2*2b Ax A z AzbAx Az Az b Ax A z Az b Ax b Ax b Ax Az b Ax Az b Ax bz x A bAv T T TTTTTT -++-=+-+-+--=+-+-=-+=- 由于上式第二项大于等于零,第三项为零,故*x 是极小点。

最小二乘问题常用的那些优化方法

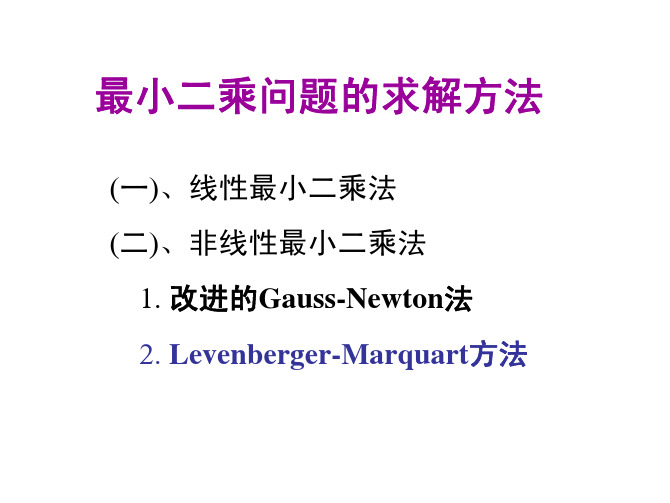

最小二乘问题常用的那些优化方法题外话:从开始学习Slam十四讲第六章的时候就开始想写一个文档整理一下这些年遇到的优化算法,一周学一章,现在都学到第9章了,总算半整理半引用整理出来了...如果学一个东西是不断坑自己+自己去填坑的过程,下一次应该不会摔的那么疼了吧对于一个最小二乘问题的求解,根据目标函数可分为线性最小二乘和非线性最小二乘;对于非线性最小二乘问题,通常是进行泰勒展开将问题线性化,求解线性增量方程或是直接迭代找到最优值;对于线性最小二乘问题,通常是直接进行展开、求导等于零,构造\(A\vec{x}=\vec{b}\)的解方程问题,使用直接分解法或是迭代法求解;写完后发现文档较长,还是列一下有些什么东西吧:•梯度下降与其扩展算法(随机梯度下降、mini-batch梯度下降以及批梯度下降)•牛顿法与其优化算法(拟牛顿法、BFGS、LBFGS、高斯牛顿法以及列文伯格-马夸尔特法)•求解线性最小二乘问题的那些:1)直接分解(LU、LUP、Cholesky分解求解方阵线性方程组问题,QR分解解决欠定方程组问题以及超定方程组的最小二乘解);2)迭代法(雅各比迭代、高斯赛德尔迭代、SOR以及超级好用的共轭梯度)•一些自己觉得不错的博客介绍;非线性最小二乘问题对于非线性最小二乘问题,通常会将目标函数进行泰勒展开,并将问题转换为一个线性求解问题:设有一个最小二乘问题:\[\min_{\vec{x}}F(\vec{x})=\frac{1}{2}||f(\vec{x})||_2 ^2\tag{1} \]有\(\vec{x}\in {R^n}, f\)是非线性函数,求解这个问题的常规思路是:1.给定某个初始值\(\vec{x}_0\)2.对于第k次迭代,寻找一个增量\(\Delta\vec{x}_k\),使得\(||f(\vec{x}_k+\Delta\vec{x}_k)||_2^2\)3.\(\Delta\vec{x}_k\)足够小,则停止4.否则,令\(\vec{x}_{k+1}=\vec{x}_k +\Delta\vec{x}_k\),返回第2步将非线性最小二乘问题求解的目标:从寻找最优值转换为寻找最小的\(\Delta\vec{x}_k\),当函数下降到\(\Delta\vec{x}_k\)很小的时候,则等价为已找到最优值。

最优化最小二乘法例题

最优化最小二乘法例题

最小二乘法是常用的线性回归方法之一。

它可以寻找一条直线(或更高维度中的一个超平面),以最小化观测数据与该直线(或超平面)之间的垂直距离平方和。

以下为最优化最小二乘法的一个例题:

假设有以下观测数据点(x,y):

(1,3), (2,5), (3,7), (4,8), (5,9)

现在我们想要通过一条形如y=a+bx 的直线来拟合这些观测数据,其中a 和b 均为待求解的系数。

我们可以使用最小二乘法来确定最佳的系数值。

首先,我们需要将观测数据转化为矩阵形式。

设X 为一个n×2 的矩阵,其中第一列全为1,第二列为观测数据点的x 坐标:

X = [1, 1, 1, 1, 1; 1, 2, 3, 4, 5]

设Y 为一个n×1 的向量,其中每个元素为对应观测数据点的y 坐标:

Y = [3; 5; 7; 8; 9]

则拟合直线的系数便可以由下式计算得到:

β= (X^T X)^(-1) X^T Y

其中^T 表示矩阵的转置,^(-1) 表示矩阵的逆。

这个公式的求解过程可以利用现代数学软件(如MATLAB)进行求解。

在本例中,我们可以通过计算获得拟合直线y ≈1.4 + 1.3x,其中系数a≈1.4 ,b≈1.3。

此外,我们还可以计算出该拟合直线与观测数据之间的误差平方和、均方根误差等指标,以评估模型的预测能力和拟合效果。

最小二乘法和最优化算法初步

最小二乘法和最优化算法初步在众多的学科中,最小二乘法和最优化算法是比较重要的概念,懂得了它们对于各种领域的研究都是有帮助的。

因此本文将对这两个概念进行初步剖析。

一、最小二乘法最小二乘法是一种统计学和数学中常用的方法,它的主要目的是通过在给定的一组数据集上进行最优的拟合来确定一个函数。

其基本思想是利用平方误差作为拟合结果的评估指标,使其最小化。

在实际应用中,最小二乘法常用于曲线拟合、回归分析、数据拟合等方面。

最小二乘法使用广泛的原因是因为它既可以使用简单的手工计算方式实现,也可以使用现代计算机技术进行高效的计算。

最小二乘法可以很方便地求出任意曲线的拟合解,尤其是对于非线性问题更为实用。

最小二乘法的优点是做出的拟合函数具有一定的泛化能力,对于未知数据也能有比较准确的拟合效果。

但其局限性是只有一个自变量的拟合问题比较简单,多个自变量的拟合问题要更复杂,并需要使用更为复杂的计算方法。

二、最优化算法最优化算法是数学和计算机科学中的一个研究方向,其目标是通过使用优化方法,寻找函数局部或者全局最小值。

最优化算法的主要应用领域包括工程设计、物理学、经济学、金融学等等。

常见的最优化算法有牛顿-拉夫森法、梯度下降法、共轭梯度法、随机梯度下降法等。

最优化算法通过对目标函数进行分析和求导,以及对目标函数的具体要求,从而对其进行调整和改进,使得求解出结果更为准确、更为快速。

最优化算法的优点在于它具有较高的求解效率和准确度,能够很好地解决一些复杂的问题。

但其缺点是它需要大量的计算资源和时间,对于特定问题的求解可能会比较困难。

三、最小二乘法与最优化算法的联系最小二乘法和最优化算法都是数学和计算机科学中重要的研究方向。

它们之间有广泛的联系和交叉研究,具体表现如下:1. 最小二乘法可以看作是求解目标函数的过程,而最优化算法可以对目标函数进行进一步的求解,并使其更加接近最优解。

2. 在求解非线性问题时,最小二乘法通常需要引入最优化算法进行优化,以使其更好地适应数据。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

10.4 最小二乘优化问题非线性最小二乘优化问题,简称LS (Least Sqaures ) 问题,它的标准形式如下:

2

1min ()(), m

n i i F x r x r r x R m n =′==∈≤∑其中称为剩余量,某些为非线性函数。

))'(,),(),(()(21x r x r x r x r r m "==)(x r i 最小二乘问题可以用无约束方法解,然而,由于它的目标函数的特殊结构,可以对某些方法进行改造,使之更简单或更有效。

在MATLAB 中,最小二乘问题的求解可由函数lsqnonlin 进行

10.4.2 lsqcurvefit

◆[beta,norm]=lsqcurvefit ('fun',beta0,xdata,ydata)以beta0为初值寻找非线性方程fun(beta,x)对数据ydata 的最小二乘最佳系数beta 。

fun 为计算以beta 和xdata 为参数的函数,norm 返回误差平方和。

◆beta=lsqcurvefit ('fun',beta0,xdata,ydata,lb,lu)lb 、ub 给出设计变量边界约束的上下界,即lb ≤x ≤ub 。

1.函数介绍

●lsqcurvefit 解非线性最小二乘问题。

lsqcurvefit 解决形如下式的问题:

min sum{(fun (beta,xdata )-ydata).^2}

x 其中fun 、xdata 和ydata 为向量, beta 是参数向量

2.函数说明。